Moov’Up

Fiche pratique sur la désindexation de contenus

Fiche pratique sur la désindexation de contenus

La désindexation c’est l’action qui consiste à supprimer de l’index d’un moteur de recherche des contenus. Les raisons sont nombreuses de désindexer des contenus et les méthodes aussi, nous allons voir ici les principales situations et méthodes. La désindexation de contenus et donc la gestion de l’indexation fait partie intégrante de l’optimisation SEO d’un site web.

noindex et disallow : il y a une différence

Quand on ne fait aucune action sur le site et qu’on ne précise aucune directive. Les robots d’indexation crawlent le site et indexent tous les contenus qu’ils souhaitent.

Toutefois, il est possible d’une part de bloquer le crawl des robots et d’autre part de rendre un contenu non indexable. Ce sont 2 actions différentes qui n’auront pas les mêmes conséquences.

Empêcher le crawl :

Quand on veut empêcher le crawl de certaines contenus ou répertoires sur le site, on utilise le fichier robots.txt sur lequel on inscrit une directive disallow pour les contenus concernés. Ce fichier indique aux robots les fichiers qu’ils peuvent, ou pas, parcourir.

MAIS ATTENTION : il ne s’agit que d’une indication, il se peut que les robots parcourent ces contenus et les indexent malgré tout, s’ils ne lisent pas le fichier. Et si le site a déjà été crawlé, le moteur de recherche peut ne pas retirer les contenus indexés.

Rendre un contenu non indexable :

Quand on ne souhaite pas qu’un contenu apparaisse dans l’index du moteur de recherche, on utilise une directive noindex. Cette action indique aux moteurs de recherche que l’on ne souhaite pas qu’ils proposent ce contenu sur ses pages de résultats.

Ainsi, le fichier robots.txt, doit préciser dès la mise en ligne les directives essentielles de crawl mais ne sert pas à contrôler la visibilité de vos contenus sur les moteurs de recherche.

A noter qu’il est déconseillé par Google de bloquer le crawl des ressources js et css.

Dans quels cas je désindexe ?

Les raisons de vouloir rendre un contenu non-indexable sont nombreuses et non-exhaustive.

Elle peut être d’abord utile ou essentielle :

- – Je travaille sur un nouveau site mais il n’est pas prêt : la version prod est en noindex pour ne pas le dévoiler avant qu’il soit terminé.

- – Mon site héberge des données que je souhaite garder confidentielles.

Mais parfois elle est aussi stratégique :

- – Je souhaite n’indexer que mes pages de qualité.

- – Je veux respecter les règles de Google, en matière de contenu dupliqué, par exemple.

- – Je veux limiter mes taux de rebond.

ATTENTION : désindexer ses contenus n’est pas une action anodine et peut avoir aussi de graves conséquences sur le référencement d’un site. Quand on se lance dans la partie stratégique, il faut être sûr de ce qu’on fait.

Le risque principal est la perte de trafic en longue traîne. Limiter l’indexation de vos contenus signifie aussi la limitation de la transmission de PR (Page Rank), les pages restantes vont avoir moins de poids aux yeux du moteur de recherche et peuvent aussi perdre en qualité à ses yeux.

Google est tout à fait capable d’analyser et réagir à de gros changements sur un site. Une désindexation en masse peut donc aussi constituer un signal négatif pour le moteur de recherche qui va interpréter cela comme la volonté de cacher des zones d’ombres. Ainsi, proposer moins de pages c’est aussi prendre le risque de générer une perte de confiance de la part du moteur de recherche.

Quels types de contenu puis-je désindexer sans risque ?

Posez-vous quelques questions avant de désindexer :

- – Mon contenu répond-t-il à la requête d’un internaute qui recherche mes contenus, produits ou services ?

- – Mon contenus a-t-il encore du sens pour mon activité ?

- – Mon contenu a-t-il du poids d’un point de vue SEO (fait-il l’objet de liens, etc) ?

Si la réponse est non à ces 3 questions : vous pouvez vous lancer !

Voici le type de fichiers avec lesquels vous ne prendrez pas de risque et cela peut même vous permettre de gagner en pertinence :

- * Les données confidentielles et tout ce qui constitue de la pré-prod (avant mise en ligne) -> indispensable

- * Pages obsolètes (contenus saisonniers ou événementiels ou produit(s) ou service(s) que vous ne proposez plus) -> recommandé

- * Moteur de recherche interne / navigation à facettes : si les pages de résultats ne sont utiles qu’à l’internaute et/ou que vous ne savez pas les gérer -> fortement recommandé

- * Contenus dupliqués -> fortement recommandé

- * Pages peu intéressantes ou peu pertinentes -> recommandé

- * Les pdf : s’ils proposent un contenu identique à une page html -> recommandé

Comment on désindexe ?

Plusieurs méthodes sont possibles.

La balise meta robots.

Placée entre les balises <head></head>, la balise meta robots permet de donner les directives d’indexation d’un contenu du site.

Elle peut indiquer qu’on est OK pour que le robot indexe le contenu et suive les liens proposés dans le contenu :

<meta name="robots" content="index, follow">

Pour rendre le contenu non indexable mais on est OK pour que les liens sur la page soient suivis (recommandé quand on veut juste qu’un contenu précis soit désindexé et que la page ne présente pas de liens problématiques) :

<meta name="robots" content="noindex, follow">

Pour rendre le contenu non indexable ET empêcher que les liens soient suivis (cette mesure limite complètement le robot qui ne continue pas le crawl à partir de cette page) :

<meta name="robots" content="noindex, follow">

ATTENTION : la balise meta ne gère pas tous les formats.

Directive x robot tag dans le .htaccess

La méthode la plus efficace car elle permet de gérer les formats que l’on souhaite désindexer. Cette directive s’affiche dans l’en-tête http du contenu grâce au fichier .htaccess. Vous pouvez gérer les formats comme vous le souhaitez.

#désindexer les fichiers pdf <Files ~ « .pdf$ »> Header set X-Robots-Tag « noindex, nofollow » </Files>

#désindexer les fichiers images <Files ~ « .(png|jpe?g|gif)$ »> Header set X-Robots-Tag « noindex » </Files>

# désindexer des URL contenant un paramètre de tri ?order=

RewriteCond %{QUERY_STRING} ^order=(.*)$ [NC]

RewriteRule . – [E=headernoindex]

Header set X-Robots-Tag « noindex, nofollow » env=headernoindex

#désindexer des dossiers admin

RewriteCond %{REQUEST_URI} ^/perso/.*$

RewriteRule . – [E=headernoindex]

Header set X-Robots-Tag « noindex » env=headernoindex

ATTENTION : dans tous les cas, vous devez choisir l’une des 2 méthodes et ne pas mettre les 2 directives en place pour un même contenu. Cela ne rendra pas l’action plus efficace !

ATTENTION aux cas particuliers : dans certains cas, comme des déclinaisons de produits sur les sites e-commerce, on privilégiera la balise rel=canonical car ces contenus dupliqués ont une raison d’être et Google est capable de l’interpréter.

Comment je peux accélérer les choses ?

La modification de ces directives n’est prise en compte qu’au prochain crawl du moteur de recherche. Si vous souhaitez accélérer un peu les choses 2 actions supplémentaires sont recommandées :

- Ajouter un sitemap dédié pour vos contenus à désindexer : il est possible de générer un sitemap pour vos contenus à désindexer. En le plaçant à la racine du site et en le soumettant sur Search Console, vous garantissez la bonne prise en compte de vos directives et cela peut vous permettre de gagner un peu de temps.

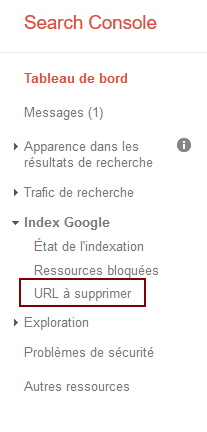

- Dans Search Console, vous avez aussi la possibilité de demander à supprimer temporairement une url de l’index. Si un contenu vous pose vraiment problème, cela peut vous permettre d’agir plus rapidement sur l’index en vous laissant le temps de faire les modifications sur votre site et que celles-ci soient prises en compte.

Et pour les pages que je supprime ?

Vous avez décidé de supprimer certains contenus de votre site car ils sont devenus obsolètes ?

La 1ère chose à faire est d’indiquer que ce contenu n’existe plus en renvoyant une réponse http 404, 410 ou 411 en en-tête du contenu concerné. Le moteur de recherche va naturellement désindexer progressivement votre contenu. A noter, qu’apparemment, le code 410 fonctionne mieux.

Parfois, le moteur de recherche peut mettre beaucoup de temps pour supprimer le contenu en 404 de son index. Si votre contenu est problématique, vous pouvez ajouter une en-tête x robot tag sur le contenu afin d’accélérer un peu les choses.

ATTENTION à la suppression des contenus : il se peut que le contenu supprimé ait une valeur SEO (soit qu’il correspond à une expression longue traîne ou qu’il recevait de bons liens) : dans ce cas, nous vous recommandons de NE PAS désindexer cette page mais de renvoyer l’url en 404 vers une page proche ou équivalente via une redirection 301.

- Quelle différence entre noindex et disallow ?

- Pourquoi désindexer ?

- Quels types de contenus je peux désindexer sans risque ?

- Comment je désindexe ?

- Accélérer le processus ?

- Le cas des pages supprimées

Allez plus loin :

♥ SEO et mobile : quelle configuration mobile selon mon site ?